Mehr über KI

Oh, was für eine Ironie.

Am Sonntagabend moderierte Dunja Hayali im „heute journal“ einen Beitrag über die „Gewalt“ und „Willkür“ der US-Migrationsbehörde ICE an, und sie erwähnte dabei ausdrücklich, wie viele Fakes dazu im Internet kursieren. Wörtlich sagte Hayali zu Beginn ihrer Moderation:

„Wer in den Sozialen Netzwerken unterwegs ist, wird festgestellt haben, dass es sehr viele Videos zu den Einsätzen der ICE-Truppen von Donald Trump gibt. Nicht alle sind echt, aber doch sehr viele.“

Im anschließenden Beitrag ging es dann aber nicht um KI-Fakes, auch nicht im Off-Text, sondern um die realen ICE-Einsätze und ihre Auswirkungen – vor allem auf migrantische Familien und ihre Kinder. Das ZDF arbeitete darin mit echten Bildern – und mit ganz offensichtlich falschen, die das ZDF aber als echte ausgab. Wie dumm.

„Es sind brutale ICE-Einsätze wie diese, die ihnen Angst machen“, hieß es im Off-Text des Beitrags an einer Stelle. Kurz danach war unter anderem zu sehen, wie zwei vermeintliche Polizisten scheinbar eine weinende Frau abführen, während zwei Kinder verzweifelt an ihr zerren. ICE-„Agenten“ führten „Eltern vor den Augen ihrer Kinder ab“, textete die Sprecherin über die Bilder.

Dass der Clip nicht echt ist, konnte man sehen, weil im Bild das Logo von Sora (siehe oben) eingeblendet war, einer künstlichen Intelligenz, mit der sich real wirkende Videos erstellen lassen. Das Logo baut die KI selbst ein. Zuschauern, denen das auffiel, wiesen den Sender darauf hin.

Aber wie kann es sein, dass so ein Fake-Video in einen ZDF-Beitrag eingebaut wird – und dass das beim Sender niemand bemerkt hat, irgendwo im langen Produktionsablauf?

Auf unsere Anfrage antwortet das ZDF mit einer kuriosen Begründung: Die mit KI generierten Bilder im Beitrag hätten „gekennzeichnet werden müssen“, schreibt ein Sprecher.

„Diese Kennzeichnung wurde bei der Überspielung des Beitrags aus technischen Gründen nicht übertragen. Die Redaktion hat den Fehler korrigiert und das Video entsprechend angepasst.“

Mal abgesehen davon, dass die Bilder ja gekennzeichnet waren, nur eben nicht vom ZDF: Sie hatten in dem Film grundsätzlich nichts verloren. Dieser Beitrag sagt ja nicht: Hier, so sehen diese Fakes aus, über die unsere Moderatorin schon sprach. Dieser Beitrag sagt: Hier, ich zeige die Wirklichkeit (oder jedenfalls Ausschnitte davon). Neben authentischen Szenen diente das KI-Video als vermeintlicher Beleg für das brutale Vorgehen von ICE.

In der ZDF-Redaktion scheint man das insgeheim genauso zu sehen. Warum sonst hat man die Szene nun im Zuge dieser „Anpassung“ aus dem Beitrag entfernt – und nicht einfach „gekennzeichnet“?

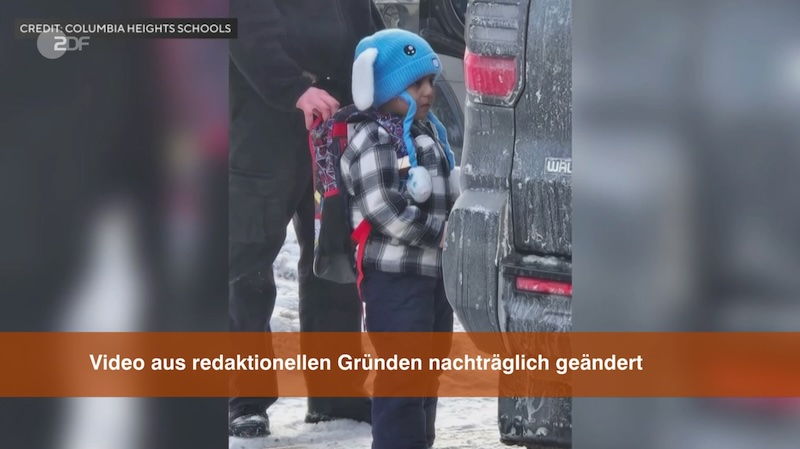

Und es kommt noch doller: Eine weitere Szene wurde ebenfalls gelöscht. Dort war zu sehen, wie ein Junge von einem Sheriff abgeführt wird. Auch das ist kein ICE-Einsatz. Aber auch keine KI-Fälschung. Wie unter anderem „Bild“ berichtet, ist es ein Video von 2022, das einen Jungen zeigt, der einen Amoklauf angedroht hatte und deshalb festgenommen wurde – zu sehen hier in einem Beitrag von CBS News.

Die Version aber, die das ZDF ausgestrahlt hat, war falsch und irreführend als ICE-Einsatz beschriftet. Anscheinend nicht vom ZDF selbst, sondern offenbar von irgendwem irgendwo im Internet. Das ZDF hat das dann so übernommen.

Und wieder ist niemandem beim ZDF aufgefallen, dass sie da mit altem, falschem Material arbeiten? Niemand hat es geprüft?

Nicht nur der Beitrag ist völlig verkorkst und ärgerlich, auch der ganze Korrekturprozess. Nachdem das ZDF die Folge nach Presseanfragen und Hinweisen von Zuschauern von seiner Seite genommen hatte, veröffentlichte es sie kurze Zeit später neu. An der bearbeiteten Stelle findet sich nun die gleichzeitig viel- und nichtssagende Einblendung:

„Video aus redaktionellen Gründen nachträglich geändert“.

Das ist so Usus, wenn Beiträge geändert werden, aber: Was heißt das?

Wer mehr darüber wissen will, muss die gut versteckte Korrekturen-Seite des ZDF finden. Wo dann aber nur jene Sätze stehen, die das ZDF auch auf Anfrage an Journalisten verschickt: Dass KI-generierte Bilder nicht gekennzeichnet wurden und man das „entsprechend angepasst“ habe, weil nach dem „KI-Grundsätzen des ZDF“ KI-generierte Bilder „immer transparent gekennzeichnet“ werden müssten.

Um es noch mal zu sagen: Das ist Bullshit.

In dem ganzen Beitrag ging und geht es nicht um KI-Fakes, davon war nur kurz in Hayalis Moderation die Rede. Es geht um das, was real in den USA passiert, und was die vielen (echten) Bilder der vielen echten ICE-Einsätze anrichten.

Dennoch behauptet der ZDF-Sprecher stoisch auf unsere verwunderte Nachfrage, wie es vor diesem Hintergrund legitim sein kann, KI-Bilder zu verwenden:

„Der Beitrag zeigt, dass sowohl mit echten als auch mit KI-generierten Bildern ein Klima der Angst erzeugt wird.“

Nein.

„Wir bedauern, dass dabei nicht deutlich genug wurde, welche Bilder real sind und welche nicht.“

Ja, bedauerlich. Und nicht nur das, sondern der ganze Umgang damit. Zumal das ZDF nirgends erwähnt, dass sie nicht nur KI-Bilder verwendet haben, sondern wohl auch eine Aufnahme von 2022 in einem falschen Kontext.

Wieso sagt das ZDF nicht, dass ihm hier dumme Fehler unterlaufen sind? Weshalb verklärt das ZDF diese Fehler auch noch nachträglich und macht es damit schlimmer? Es ist ein gefundenes Fressen für all jene, die ARD und ZDF sowieso einstampfen wollen. Und bei allen anderen beschädigt es zwangsläufig restliches Vertrauen.

Die Gefahr solcher KI-Bilder ist nicht nur, dass sie Lügen verbreiten, indem sie eine Realität suggerieren, die es nicht gibt. Sie säen auch grundsätzliche Zweifel, ob die echten Bilder wirklich echt sind. Das ist gefährlich. Und besonders gefährlich ist es, wenn solche KI-Bilder in Tageszeitungen laden, wie kürzlich. Oder in einer öffentlich-rechtlichen Nachrichtensendung, die dann im Nachgang nicht mal seriös und selbstkritisch darüber aufklärt, sondern abermals Falschbehauptungen verbreitet. Vielleicht sollte sich beim ZDF mal irgendwer Gedanken machen, welche Konsequenzen das nun hat.

Wir wollten vom ZDF noch wissen, ob und wie Videos in der Redaktion verifiziert werden, welche Vorgaben es dazu gibt, auch in Hinblick auf KI, und wer verantwortlich ist für deren Einhaltung. Aber wer rechnet da mit Transparenz? Das ZDF hat die Fragen nicht beantwortet. Und in der Ausgabe des „heute journals“ am Montagabend: kein Wort zu den gravierenden Fehlern des Vortags. Dabei wäre gerade das der Ort für eine Richtigstellung. Doch beim ZDF haben sie ja offenbar nicht mal wirklich ein Einsehen.

Ergänzung, 17.2.2026: Das ZDF hat um 12:40 Uhr eine Pressemitteilung veröffentlicht. Darin sagt Anne Gellinek, stellvertretende Chefredakteurin und Leiterin der Aktualität:

„Wir entschuldigen uns in aller Form für diese Fehler. Der Beitrag entspricht nicht unseren Standards und hätte in dieser Form nicht gesendet werden dürfen. Wir haben ihn deshalb von allen Plattformen entfernt und werden auf ZDFheute sowie an gleicher Stelle im ‚heute journal‘ heute Abend korrigierend berichten.“

Boris Rosenkranz ist Gründer von Übermedien. Er hat in Bochum Literaturwissenschaften, Soziologie und Politik studiert. Er war Redakteur bei der „taz“, hat beim Norddeutschen Rundfunk in Hamburg volontiert und für verschiedene ARD-Redaktionen gearbeitet, insbesondere für das Medienmagazin „Zapp“ und das Satiremagazin „Extra 3“.

Alexander Graf ist Chefredakteur von Übermedien. Davor hat er in gleicher Position das „Medium Magazin“ verantwortet. Er hat in Heidelberg und Rom Philosophie, Geschichte und Politikwissenschaften studiert, war Redakteur der „Rheinpfalaz“ in Ludwigshafen und hat anschließend als freier Journalist mit den Schwerpunkten Wissenschaft und Medien für verschiedene Redaktionen gearbeitet, unter anderem für die „taz“ und „Zeit Online“.

Sie müssen den Inhalt von reCAPTCHA laden, um das Formular abzuschicken. Bitte beachten Sie, dass dabei Daten mit Drittanbietern ausgetauscht werden.

Mehr InformationenSie sehen gerade einen Platzhalterinhalt von Turnstile. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf die Schaltfläche unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Mehr InformationenSie sehen gerade einen Platzhalterinhalt von Facebook. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf die Schaltfläche unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Mehr InformationenSie sehen gerade einen Platzhalterinhalt von Instagram. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf die Schaltfläche unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Mehr InformationenSie sehen gerade einen Platzhalterinhalt von X. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf die Schaltfläche unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Mehr Informationen

No comment?

Um kommentieren zu können, müssen Sie Übonnent sein.